使用 Google Colab 训练的图像分类模型

介绍

图像分类是按照预先确定的原则对图像内的像素组进行分类和识别的过程。在创建分类规则时使用一种或多种光谱或文本质量是可行的。两种流行的分类技术是“有监督的”和“无监督的”。

图像分类如何工作?

使用标记的样本照片,训练模型以检测目标类别(要在图像中识别的对象)。监督学习的一个例子是图像分类。原始像素数据是早期计算机视觉算法的唯一输入。

然而,单独的像素数据并不能提供足够一致的表示来包含图像中表示的项目的许多振荡。对象的位置、其背景、环境照明、相机角度和相机焦距都会影响原始像素数据。

传统的计算机视觉模型添加了源自像素数据的新组件,例如纹理、颜色直方图和形状,以更灵活地对对象进行建模。这种方法的缺点是特征工程变得非常耗时,因为需要更改大量输入。

哪些色调对猫的分类至关重要?形状的定义应该有多灵活?由于特征必须精确地调整,因此很难创建稳健的模型。

训练图像分类模型

本教程使用了一个基本的机器学习工作流程:

· 分析数据集

· 创建输入管道

· 建立模型

· 训练模型

· 分析模型

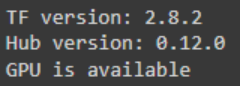

设置和导入 TensorFlow 和其他库

import itertools

import os

import matplotlib.pylab as plt

import numpy as np

import tensorflow as tf

import tensorflow_hub as hub

print("TF version:", tf.__version__)

print("Hub version:", hub.__version__)

print("GPU is", "available" if tf.config.list_physical_devices('GPU') else "NOT AVAILABLE")

输出如下所示:

选择要使用的 TF2 Saved Model Module

请注意,TF1 Hub 格式的模型在这里不起作用。

有许多模型可以工作。只需从下面单元格中的列表中选择一个不同的选项,然后继续使用Notebook。

在这里,我选择 了 Inception_v3 并自动从下面的列表中选择图像大小为299 x 299。

model_name = "resnet_v1_50" # @param ['efficientnetv2-s', 'efficientnetv2-m', 'efficientnetv2-l', 'efficientnetv2-s-21k', 'efficientnetv2-m-21k', 'efficientnetv2-l-21k', 'efficientnetv2-xl-21k', 'efficientnetv2-b0-21k', 'efficientnetv2-b1-21k', 'efficientnetv2-b2-21k', 'efficientnetv2-b3-21k', 'efficientnetv2-s-21k-ft1k', 'efficientnetv2-m-21k-ft1k', 'efficientnetv2-l-21k-ft1k', 'efficientnetv2-xl-21k-ft1k', 'efficientnetv2-b0-21k-ft1k', 'efficientnetv2-b1-21k-ft1k', 'efficientnetv2-b2-21k-ft1k', 'efficientnetv2-b3-21k-ft1k', 'efficientnetv2-b0', 'efficientnetv2-b1', 'efficientnetv2-b2', 'efficientnetv2-b3', 'efficientnet_b0', 'efficientnet_b1', 'efficientnet_b2', 'efficientnet_b3', 'efficientnet_b4', 'efficientnet_b5', 'efficientnet_b6', 'efficientnet_b7', 'bit_s-r50x1', 'inception_v3', 'inception_resnet_v2', 'resnet_v1_50', 'resnet_v1_101', 'resnet_v1_152', 'resnet_v2_50', 'resnet_v2_101', 'resnet_v2_152', 'nasnet_large', 'nasnet_mobile', 'pnasnet_large', 'mobilenet_v2_100_224', 'mobilenet_v2_130_224', 'mobilenet_v2_140_224', 'mobilenet_v3_small_100_224', 'mobilenet_v3_small_075_224', 'mobilenet_v3_large_100_224', 'mobilenet_v3_large_075_224']

model_handle_map = {

"efficientnetv2-s": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet1k_s/feature_vector/2",

"efficientnetv2-m": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet1k_m/feature_vector/2",

"efficientnetv2-l": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet1k_l/feature_vector/2",

"efficientnetv2-s-21k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_s/feature_vector/2",

"efficientnetv2-m-21k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_m/feature_vector/2",

"efficientnetv2-l-21k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_l/feature_vector/2",

"efficientnetv2-xl-21k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_xl/feature_vector/2",

"efficientnetv2-b0-21k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_b0/feature_vector/2",

"efficientnetv2-b1-21k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_b1/feature_vector/2",

"efficientnetv2-b2-21k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_b2/feature_vector/2",

"efficientnetv2-b3-21k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_b3/feature_vector/2",

"efficientnetv2-s-21k-ft1k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_ft1k_s/feature_vector/2",

"efficientnetv2-m-21k-ft1k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_ft1k_m/feature_vector/2",

"efficientnetv2-l-21k-ft1k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_ft1k_l/feature_vector/2",

"efficientnetv2-xl-21k-ft1k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_ft1k_xl/feature_vector/2",

"efficientnetv2-b0-21k-ft1k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_ft1k_b0/feature_vector/2",

"efficientnetv2-b1-21k-ft1k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_ft1k_b1/feature_vector/2",

"efficientnetv2-b2-21k-ft1k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_ft1k_b2/feature_vector/2",

"efficientnetv2-b3-21k-ft1k": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet21k_ft1k_b3/feature_vector/2",

"efficientnetv2-b0": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet1k_b0/feature_vector/2",

"efficientnetv2-b1": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet1k_b1/feature_vector/2",

"efficientnetv2-b2": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet1k_b2/feature_vector/2",

"efficientnetv2-b3": "https://tfhub.dev/google/imagenet/efficientnet_v2_imagenet1k_b3/feature_vector/2",

"efficientnet_b0": "https://tfhub.dev/tensorflow/efficientnet/b0/feature-vector/1",

"efficientnet_b1": "https://tfhub.dev/tensorflow/efficientnet/b1/feature-vector/1",

"efficientnet_b2": "https://tfhub.dev/tensorflow/efficientnet/b2/feature-vector/1",

"efficientnet_b3": "https://tfhub.dev/tensorflow/efficientnet/b3/feature-vector/1",

"efficientnet_b4": "https://tfhub.dev/tensorflow/efficientnet/b4/feature-vector/1",

"efficientnet_b5": "https://tfhub.dev/tensorflow/efficientnet/b5/feature-vector/1",

"efficientnet_b6": "https://tfhub.dev/tensorflow/efficientnet/b6/feature-vector/1",

"efficientnet_b7": "https://tfhub.dev/tensorflow/efficientnet/b7/feature-vector/1",

"bit_s-r50x1": "https://tfhub.dev/google/bit/s-r50x1/1",

"inception_v3": "https://tfhub.dev/google/imagenet/inception_v3/feature-vector/4",

"inception_resnet_v2": "https://tfhub.dev/google/imagenet/inception_resnet_v2/feature-vector/4",

"resnet_v1_50": "https://tfhub.dev/google/imagenet/resnet_v1_50/feature-vector/4",

"resnet_v1_101": "https://tfhub.dev/google/imagenet/resnet_v1_101/feature-vector/4",

"resnet_v1_152": "https://tfhub.dev/google/imagenet/resnet_v1_152/feature-vector/4",

"resnet_v2_50": "https://tfhub.dev/google/imagenet/resnet_v2_50/feature-vector/4",

"resnet_v2_101": "https://tfhub.dev/google/imagenet/resnet_v2_101/feature-vector/4",

"resnet_v2_152": "https://tfhub.dev/google/imagenet/resnet_v2_152/feature-vector/4",

"nasnet_large": "https://tfhub.dev/google/imagenet/nasnet_large/feature_vector/4",

"nasnet_mobile": "https://tfhub.dev/google/imagenet/nasnet_mobile/feature_vector/4",

"pnasnet_large": "https://tfhub.dev/google/imagenet/pnasnet_large/feature_vector/4",

"mobilenet_v2_100_224": "https://tfhub.dev/google/imagenet/mobilenet_v2_100_224/feature_vector/4",

"mobilenet_v2_130_224": "https://tfhub.dev/google/imagenet/mobilenet_v2_130_224/feature_vector/4",

"mobilenet_v2_140_224": "https://tfhub.dev/google/imagenet/mobilenet_v2_140_224/feature_vector/4",

"mobilenet_v3_small_100_224": "https://tfhub.dev/google/imagenet/mobilenet_v3_small_100_224/feature_vector/5",

"mobilenet_v3_small_075_224": "https://tfhub.dev/google/imagenet/mobilenet_v3_small_075_224/feature_vector/5",

"mobilenet_v3_large_100_224": "https://tfhub.dev/google/imagenet/mobilenet_v3_large_100_224/feature_vector/5",

"mobilenet_v3_large_075_224": "https://tfhub.dev/google/imagenet/mobilenet_v3_large_075_224/feature_vector/5",

}

model_image_size_map = {

"efficientnetv2-s": 384,

"efficientnetv2-m": 480,

"efficientnetv2-l": 480,

"efficientnetv2-b0": 224,

"efficientnetv2-b1": 240,

"efficientnetv2-b2": 260,

"efficientnetv2-b3": 300,

"efficientnetv2-s-21k": 384,

"efficientnetv2-m-21k": 480,

"efficientnetv2-l-21k": 480,

"efficientnetv2-xl-21k": 512,

"efficientnetv2-b0-21k": 224,

"efficientnetv2-b1-21k": 240,

"efficientnetv2-b2-21k": 260,

"efficientnetv2-b3-21k": 300,

"efficientnetv2-s-21k-ft1k": 384,

"efficientnetv2-m-21k-ft1k": 480,

"efficientnetv2-l-21k-ft1k": 480,

"efficientnetv2-xl-21k-ft1k": 512,

"efficientnetv2-b0-21k-ft1k": 224,

"efficientnetv2-b1-21k-ft1k": 240,

"efficientnetv2-b2-21k-ft1k": 260,

"efficientnetv2-b3-21k-ft1k": 300,

"efficientnet_b0": 224,

"efficientnet_b1": 240,

"efficientnet_b2": 260,

"efficientnet_b3": 300,

"efficientnet_b4": 380,

"efficientnet_b5": 456,

"efficientnet_b6": 528,

"efficientnet_b7": 600,

"inception_v3": 299,

"inception_resnet_v2": 299,

"nasnet_large": 331,

"pnasnet_large": 331,

}

model_handle = model_handle_map.get(model_name)

pixels = model_image_size_map.get(model_name, 224)

print(f"Selected model: {model_name} : {model_handle}")

IMAGE_SIZE = (pixels, pixels)

print(f"Input size {IMAGE_SIZE}")

BATCH_SIZE = 16#@param {type:"integer"}

输入为所选模块正确缩放。更大的数据集有助于训练,尤其是在微调时(即每次读取图像时图像的随机失真)。

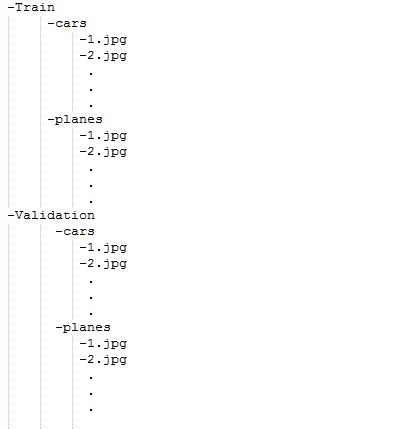

我们的数据集应该如下图所示进行组织。

我们的自定义数据集现在必须上传到云端硬盘。一旦我们的数据集需要扩充,我们必须将数据扩充参数设置为 true。

data_dir = "/content/Images"

def build_dataset(subset):

return tf.keras.preprocessing.image_dataset_from_directory(data_dir,validation_split=.10,subset=subset,label_mode="categorical",seed=123,image_size=IMAGE_SIZE,batch_size=1)

train_ds = build_dataset("training")

class_names = tuple(train_ds.class_names)

train_size = train_ds.cardinality().numpy()

train_ds = train_ds.unbatch().batch(BATCH_SIZE)

train_ds = train_ds.repeat()

normalization_layer = tf.keras.layers.Rescaling(1. / 255)

preprocessing_model = tf.keras.Sequential([normalization_layer])

do_data_augmentation = False #@param {type:"boolean"}

if do_data_augmentation:

preprocessing_model.add(tf.keras.layers.RandomRotation(40))

preprocessing_model.add(tf.keras.layers.RandomTranslation(0, 0.2))

preprocessing_model.add(tf.keras.layers.RandomTranslation(0.2, 0))

# Like the old tf.keras.preprocessing.image.ImageDataGenerator(),

# image sizes are fixed when reading, and then a random zoom is applied.

# RandomCrop with a batch size of 1 and rebatch later.

preprocessing_model.add(tf.keras.layers.RandomZoom(0.2, 0.2))

preprocessing_model.add(tf.keras.layers.RandomFlip(mode="horizontal"))

train_ds = train_ds.map(lambda images, labels:(preprocessing_model(images), labels))

val_ds = build_dataset("validation")

valid_size = val_ds.cardinality().numpy()

val_ds = val_ds.unbatch().batch(BATCH_SIZE)

val_ds = val_ds.map(lambda images, labels:(normalization_layer(images), labels))

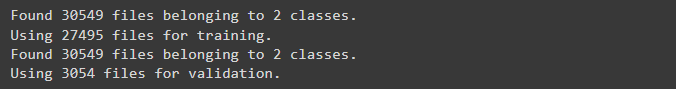

输出:

定义模型

所需要做的就是使用 Hub 模块在特征提取器层之上分层线性分类器。

我们最初使用不可训练的特征提取器层来提高速度,但你也可以启用微调以获得更好的精度。

do_fine_tuning = True

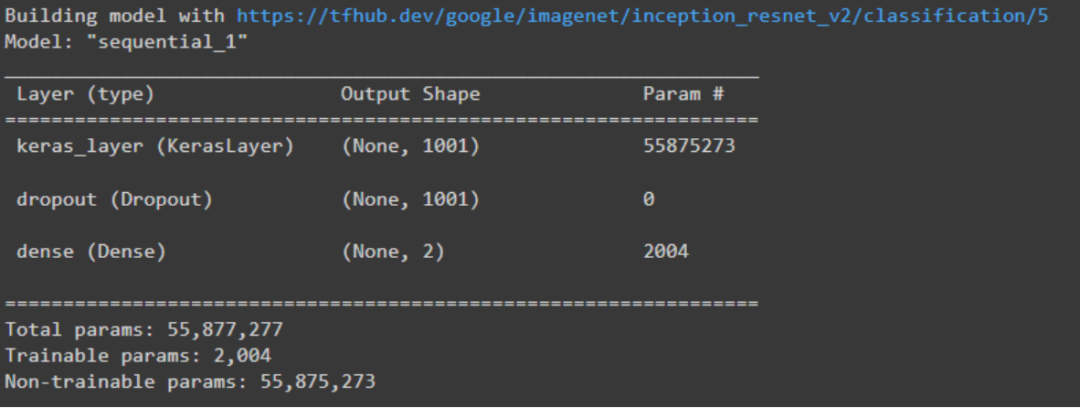

print("Building model with", model_handle)

model = tf.keras.Sequential([

# Explicitly define the input shape so the model can be properly

# loaded by the TFLiteConverter

tf.keras.layers.InputLayer(input_shape=IMAGE_SIZE + (3,)),

hub.KerasLayer(model_handle),

tf.keras.layers.Dropout(rate=0.2),

tf.keras.layers.Dense(len(class_names),activation='sigmoid',

kernel_regularizer=tf.keras.regularizers.l2(0.0001))

])

model.build((None,)+IMAGE_SIZE+(3,))

model.summary()

输出如下

模型训练

model.compile(

optimizer=tf.keras.optimizers.SGD(learning_rate=0.005, momentum=0.9),

loss=tf.keras.losses.CategoricalCrossentropy(from_logits=True, label_smoothing=0.1),

metrics=['accuracy'])

steps_per_epoch = train_size // BATCH_SIZE

validation_steps = valid_size // BATCH_SIZE

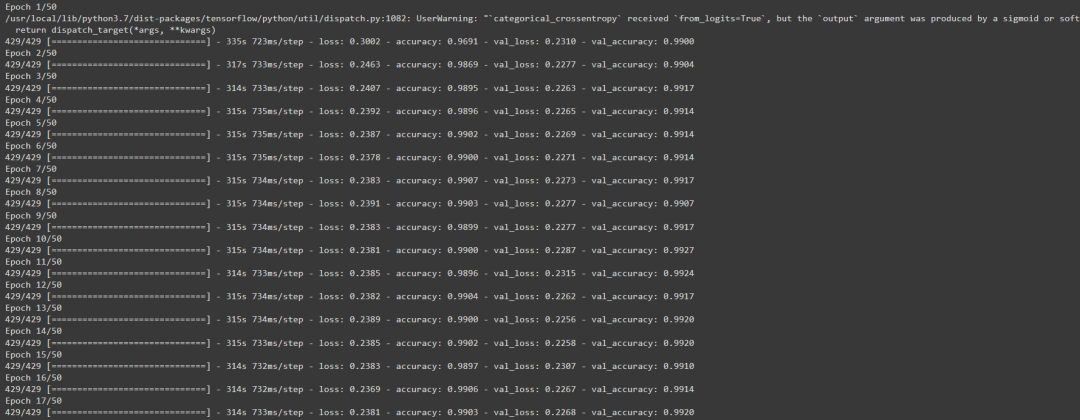

hist = model.fit(

train_ds,

epochs=50, steps_per_epoch=steps_per_epoch,

validation_data=val_ds,

validation_steps=validation_steps).history

输出如下所示:

训练完成后,我们需要使用以下代码保存模型:

model.save ("save_locationmodelname.h5")

结论

这篇博文使用卷积神经网络(CNN) 根据图片的视觉内容对图片进行分类。该数据集用于测试和训练 CNN。其准确率大于 98%。我们必须使用微小的灰度图像作为我们的教学资源。与其他常规 JPEG 照片相比,这些照片需要大量的处理时间。用于在 GPU 集群上训练网络的具有更多层和更多图片数据的模型将更准确地对图像进行分类。未来的发展将集中在对图像分割过程非常有用的巨大彩色图像的分类上。

关键要点

· 图像分类是计算机视觉的一个分支,它使用一组经过算法训练的指定标签或类别对图像内的像素或矢量集进行分类和标记。

· 可以区分有监督和无监督分类。

· 在监督分类中,分类算法使用一组图像及其相关标签进行训练。

· 无监督分类算法仅使用原始数据进行训练。

· 你需要大量具有准确标记数据的数据集来创建值得信赖的图片分类器。

原文标题:使用 Google Colab 训练的图像分类模型

-

高性能图像传感器的供电

2022-09-14 -

建立重复图像查找系统

2022-09-14 -

使用U-Net方法对航空图像进行语义分割

2022-09-09 -

SageMaker TensorFlow对象检测模型

2022-09-06 -

使用Pytorch进行图像增强的综合教程

2022-08-31 -

Python 3 显示图像的方法

2022-08-15 -

在 R 中使用 Keras 构建深度学习图像分类器

2022-08-11 -

使用 TensorFlow 2.x API 介绍图像中的显着性图

2022-08-08 -

使用 Fastai 构建食物图像分类器

2022-08-01 -

药物发现中的斑马鱼疾病模型

2022-07-28 -

关于图像处理和Python深度学习的教程:第二部分

2022-07-22 -

关于图像处理和Python深度学习的教程:第一部分

2022-07-19 -

基于卷积神经网络的图像分类

2022-07-14 -

Meta免费开源AI模型NLLB-200!可精准翻译超过200种语言

2022-07-08 -

中国电科院研发变电模型转换工具实现自动化系统模型向信息化系统模型的自动转换

2022-07-06